はじめに:AIで「推し」と会話する夢を実現する

「自分が作ったゲームのキャラクターと、リアルタイムで会話してみたい」

ゲーム開発者やクリエイターなら一度は夢見たことがあるのではないでしょうか。

今回は、OpenAIの最新機能「Realtime API」と、ノーコードAI基盤「Dify」を組み合わせることで、低遅延かつ高精度なキャラクター対話システムを構築する方法をご紹介します。

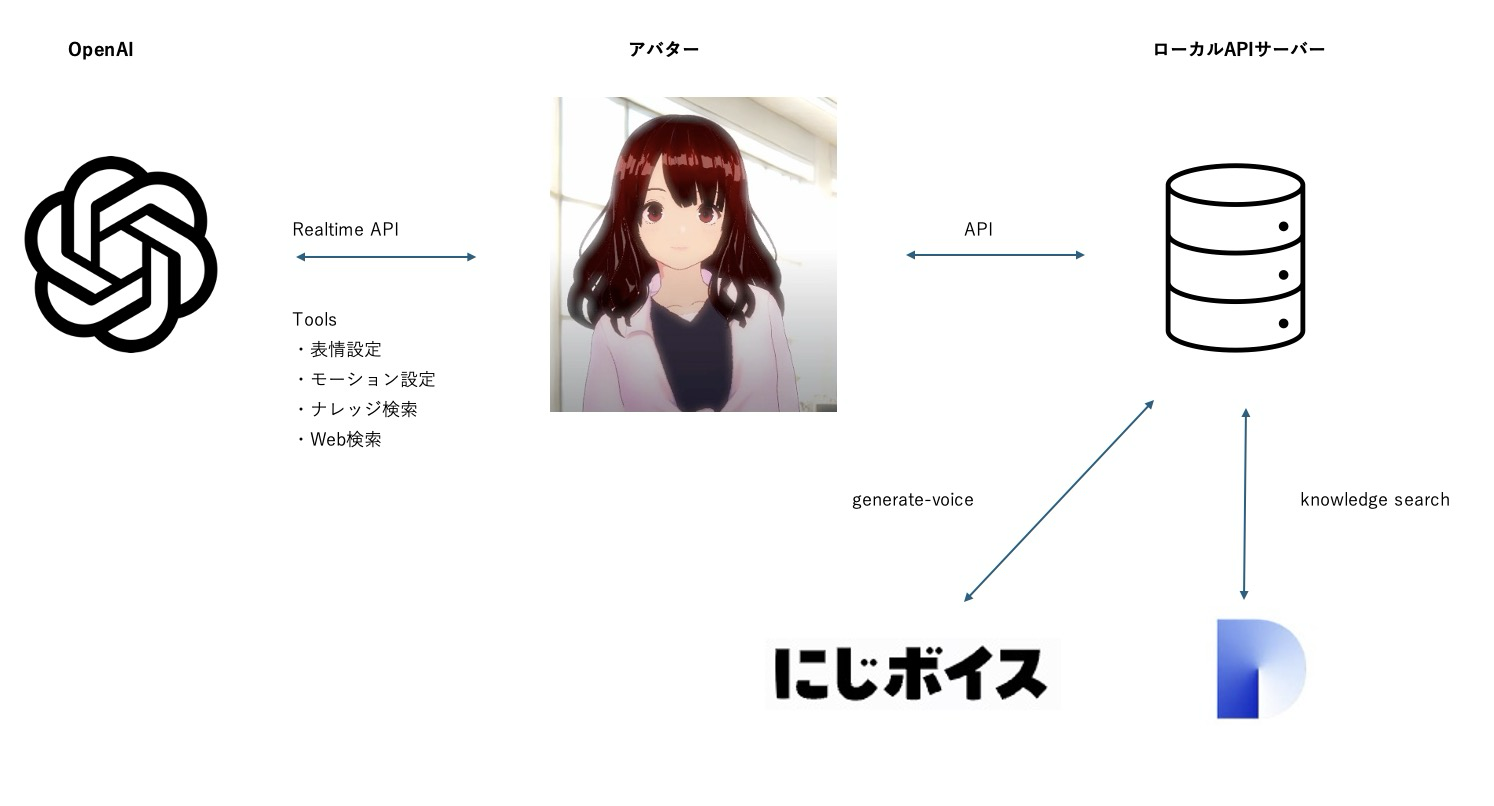

システム構成と仕組み

本システムは、以下の技術要素で構成されています。

- FastAPI(Python): 全体を制御するバックエンドサーバー

- OpenAI Realtime API: リアルタイムな音声認識と応答生成

- Dify(Docker版): キャラクターの設定やシナリオ知識(RAG)の管理

- にじボイス(API): キャラクターらしい声での音声合成

実装のポイント

1. Realtime APIの制御

OpenAIのRealtime APIを使用しますが、今回は応答の音声品質をこだわりたいため、モデルからの出力を「テキストのみ」に制限し、音声合成は別のAPI(にじボイス)を使用する構成にしました。

※セッション作成時に modalities: ["text"] を指定することで、無駄なトークン消費を抑えられます。

2. Difyによるナレッジ検索(RAG)

キャラクターに独自の知識を持たせるために、Difyの「ナレッジ機能」を活用します。

原作シナリオやキャラクター設定資料をDifyにアップロードし、API経由で検索できるように設定します。

これにより、「あなたの誕生日は?」「あの時の戦いについて教えて」といった質問に対し、設定資料に基づいた正確な回答が可能になります。

3. Tool(関数呼び出し)の実装

会話の中でDifyのナレッジを参照する必要がある場合、Realtime APIの「Function Calling」機能を使用します。

ユーザーの質問内容に応じて、自動的にDifyの検索APIを叩き、その結果を会話コンテキストに含める処理を実装します。

// Tool呼び出しの処理例(TypeScript) if (message.name === "retrieve_knowledge") { const obj = JSON.parse(message.arguments); const result = await fetchKnowledgeContent(obj.query); // Dify APIへリクエスト // 結果をAIに返す処理... }実際に動かしてみて分かったこと

コストと制限:

Realtime APIは非常に強力ですが、Rate Limit(利用制限)に引っかかりやすい点に注意が必要です。開発段階ではこまめなテストを推奨します。

応答速度とUX:

Difyへの問い合わせや音声合成の処理が入るため、若干の待ち時間が発生します。この間、キャラクターに「検索中モーション」を取らせるなどの演出を入れることで、体感的な遅延を軽減できるでしょう。

まとめ

Difyをバックエンドの知識ベースとして活用することで、複雑な設定を持つキャラクターでも容易にAI化することが可能です。

今後、デバイス上で動作する軽量なモデル(SLM)が普及すれば、さらに低遅延でリアルな対話体験が実現できるかもしれません。

【推奨】業務システム化に有効なアイテム

生成AIを学ぶ

システム化のパートナー(ミラーマスター合同会社)

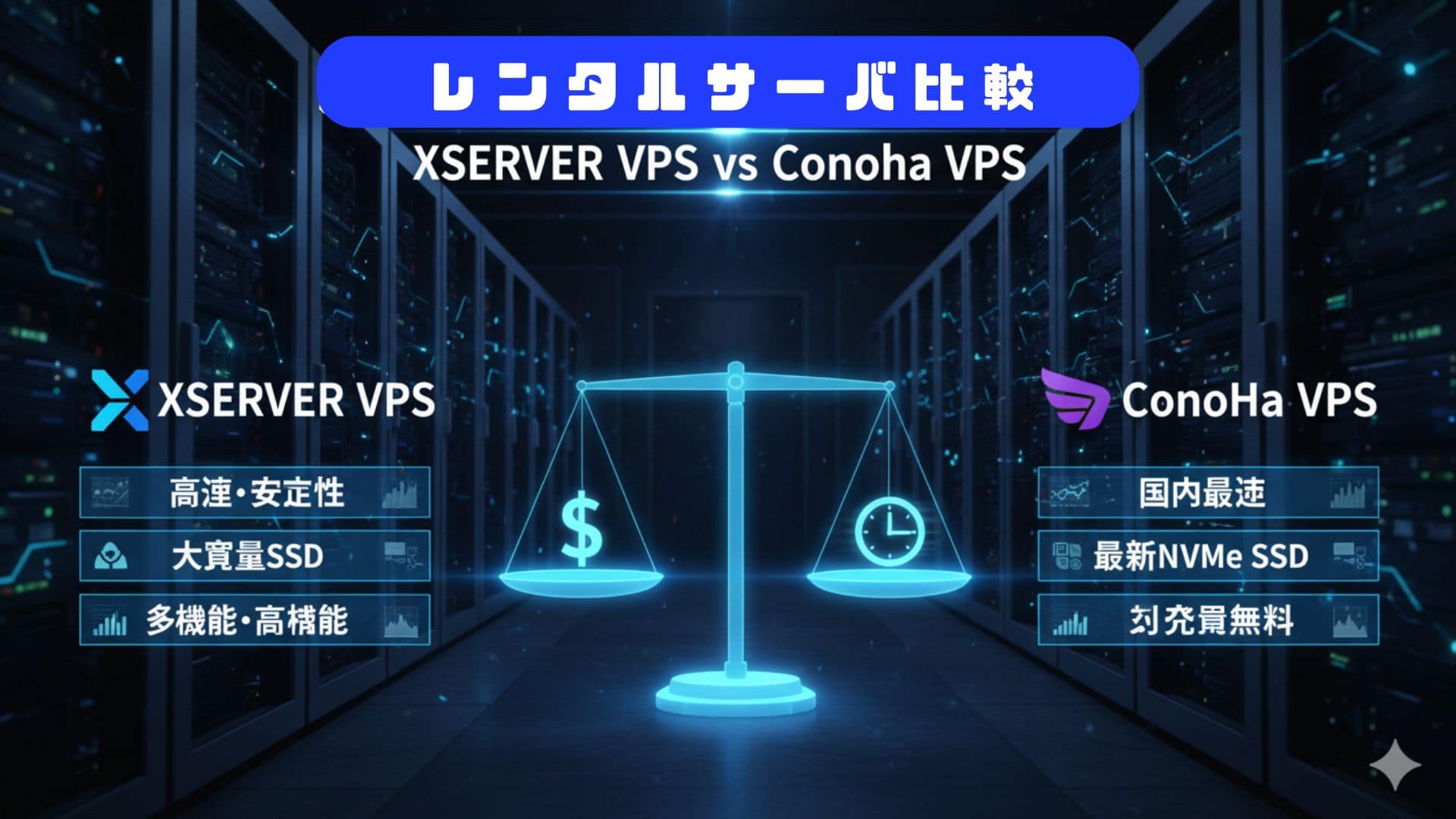

VPSサーバの選定

コメント