Difyでチャットボットを開発する際、「どのLLM(大規模言語モデル)を使えば最適な回答が得られるか」で悩むことはありませんか?

GPT-4o、Claude 3.5 Sonnet、Gemini 1.5 Pro… それぞれに特徴があり、実際のプロンプトで試してみないと分からないことも多いはずです。

そんな時に役立つのが、Difyの「複数モデルでのデバッグ」機能です。この記事では、この機能を活用して効率的にモデル選定を行う方法を解説します。

目次

複数モデルでのデバッグ機能とは?

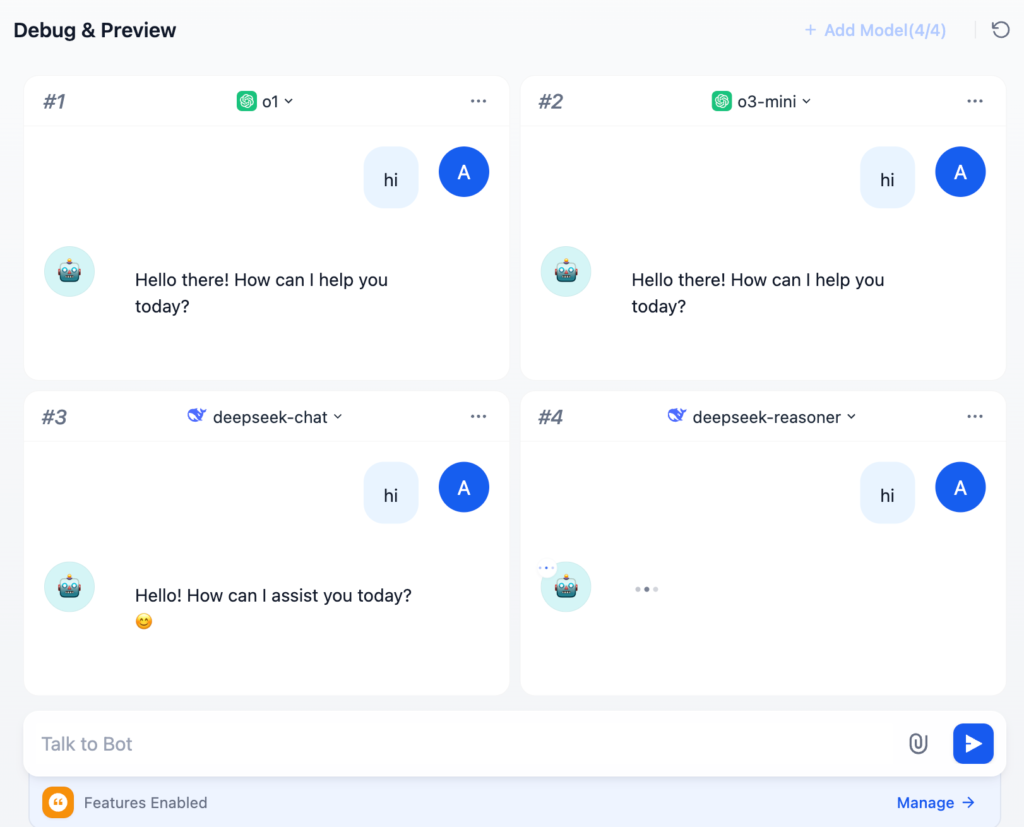

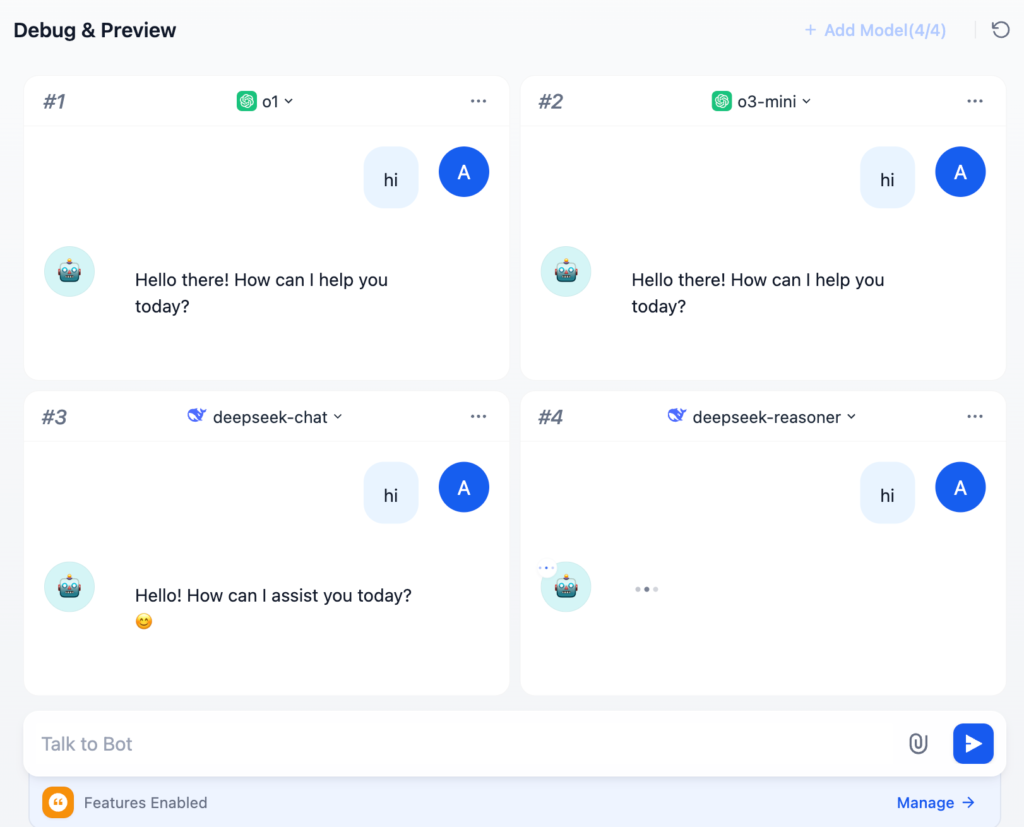

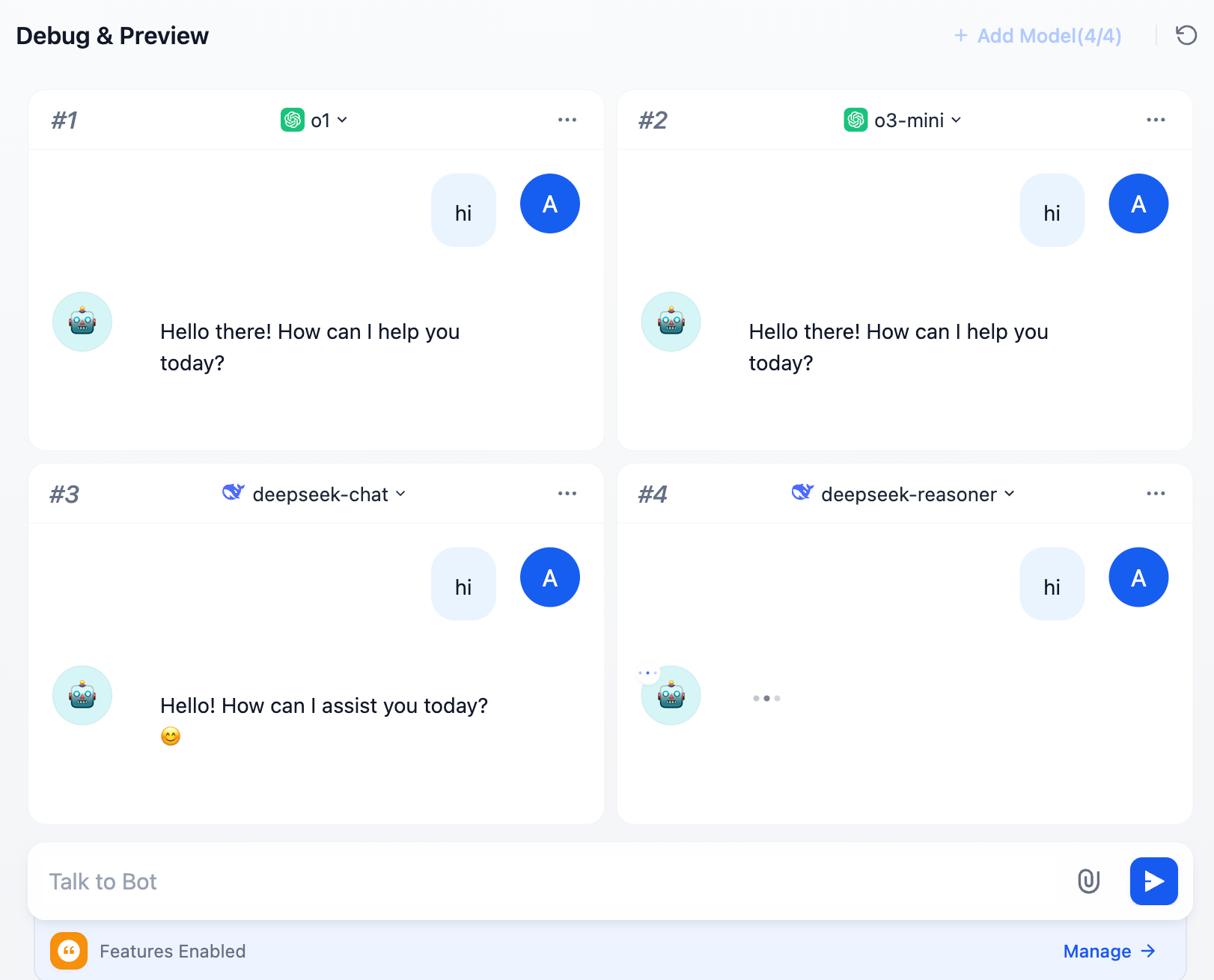

Difyのチャットボットアプリでは、1つの質問に対して、最大4つの異なるLLMからの回答を同時に生成・表示することができます。

これにより、各モデルの回答品質、生成速度、トークン消費量などを一目で比較検討することが可能です。

使い方:3ステップで簡単比較

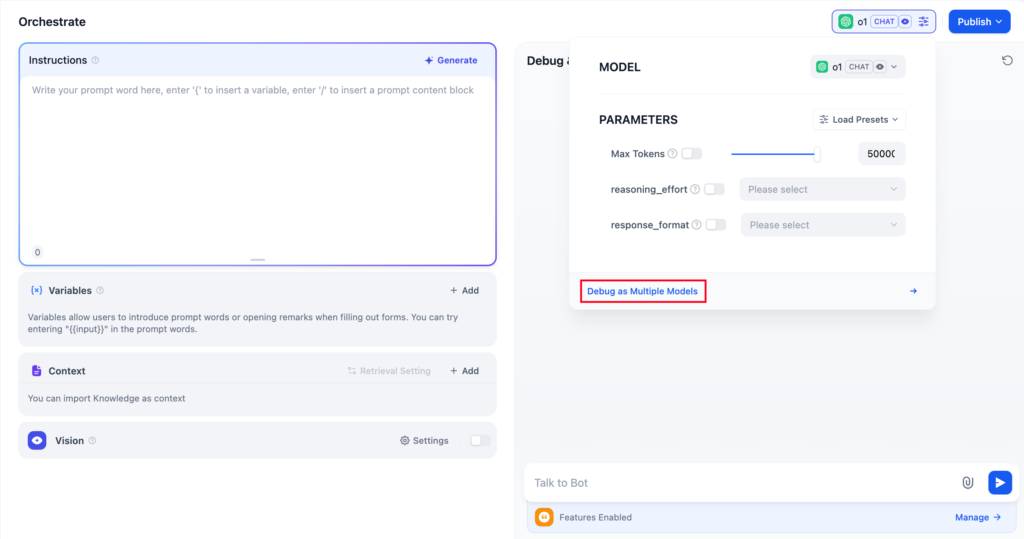

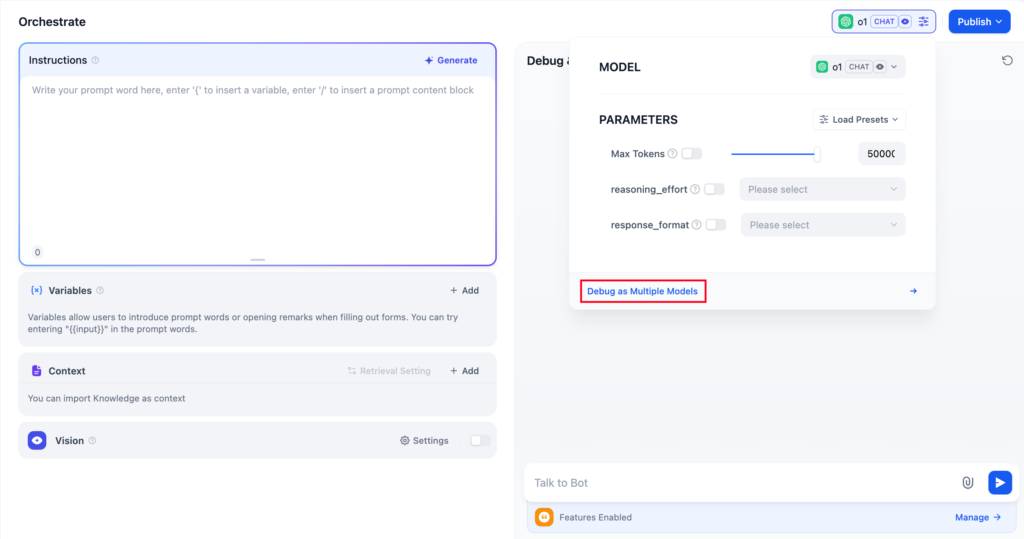

1. デバッグモードへの切り替え

チャットボットの「デバッグとプレビュー」画面を開き、画面上部にあるモード切替スイッチから「複数モデルでデバッグ」を選択します。

2. モデルの追加

比較したいモデルを追加します。「+」ボタンをクリックし、リストから検証したいモデルを選択してください。最大4つまで追加可能です。

ヒント: モデルリストに表示されない場合は、「モデルプロバイダー」設定でAPIキーが正しく登録されているか確認してください。

3. 質問を送信して比較

入力欄に質問(プロンプト)を入力して送信すると、設定した全てのモデルが一斉に回答を生成し始めます。

回答内容だけでなく、生成にかかった時間なども比較できるため、コストパフォーマンスの検証にも役立ちます。

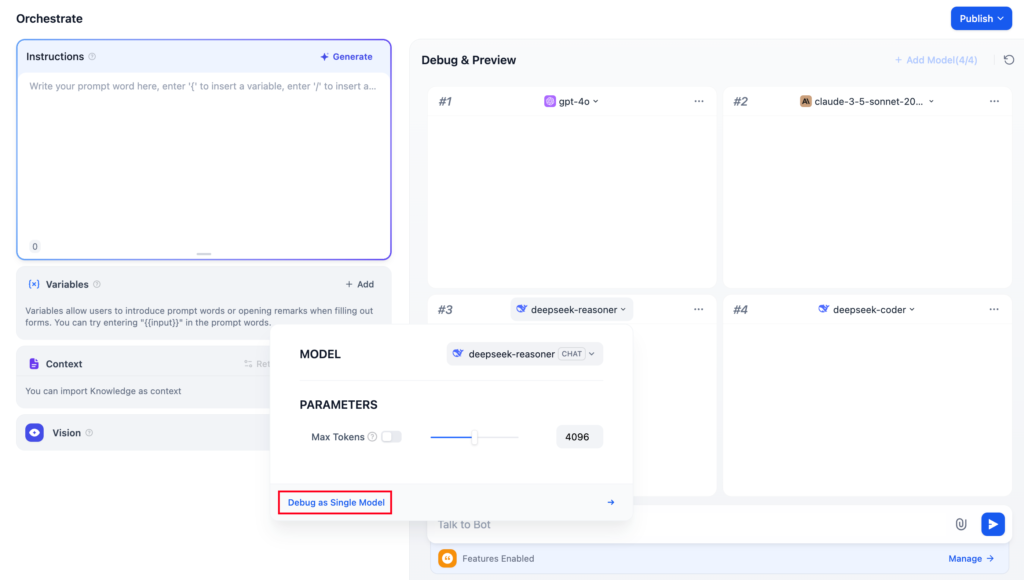

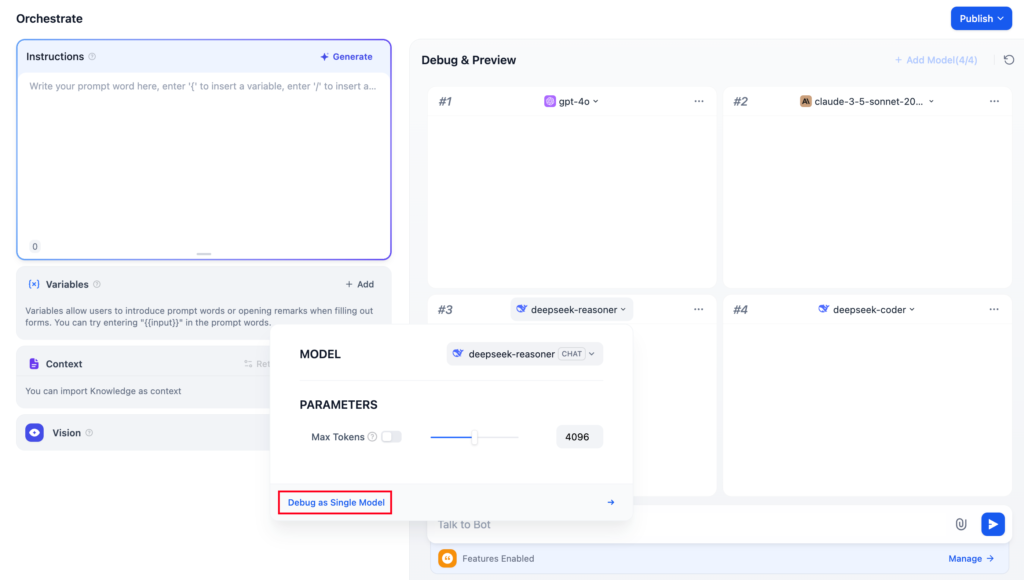

最適なモデルが決まったら

比較の結果、最も良いパフォーマンスを発揮するモデルが見つかったら、そのモデルの右上にあるメニュー(または「単一モデルでデバッグ」ボタン)をクリックします。

すると、そのモデルが選択された状態で通常の「単一モデルデバッグ」画面に戻り、開発を継続できます。

よくある質問

Q. モデル追加リストに目的のモデルが表示されません

A. Difyの「設定」→「モデルプロバイダー」画面で、そのモデルのAPIキーが正しく設定されているか確認してください。未設定のモデルはリストに表示されません。

Q. 複数モデルデバッグモードを終了するには?

A. 画面上の「単一モデルでデバッグ」をクリックするか、採用したいモデルを選択することで、通常のデバッグ画面に戻ることができます。

まとめ

Difyの「複数モデルデバッグ」機能を活用すれば、毎回モデルを切り替えてテストする必要がなくなり、開発効率が劇的に向上します。

特にRAG(検索拡張生成)などの複雑なタスクでは、モデルによって回答精度が大きく異なるため、この機能を使って最適なモデルを見つけ出すことを強くお勧めします。

【推奨】業務システム化に有効なアイテム

生成AIを学ぶ

起業のためのシステム化

【シゴトAI】実務で使えるAIスキルを最短習得!評判と特徴 – 起業のためのシステム化

実務直結のAI教育「シゴトAI」を解説。スマホ受講やLINEサポートで、初心者でも仕事や副業に活かせるスキルを習得可能。あなたに合った活用法が見つかります。

起業のためのシステム化

45歳からの生成AI!ライフシフトラボで「稼ぐ力」を習得 – 起業のためのシステム化

40代〜60代特化!知識ゼロから3ヶ月で「稼げるAIスキル」を習得するライフシフトラボ。経験×AIで起業・副業を加速させましょう。無料説明会受付中。

起業のためのシステム化

デジハクでAIを仕事に!未経験からプロを目指すマンツーマン講座 – 起業のためのシステム化

未経験からAIスキルで稼ぐ力をつけるオンラインスクール「デジハク」。マンツーマン指導と充実のアフターサポートで、副業・フリーランスへの道を最短で切り拓きます。

システム化のパートナー(ミラーマスター合同会社)

ミラーマスター合同会社|千葉のDX…

Dify自己ホスト型AIチャットボット導入支援 – ミラーマスター合同会社|千葉のDX・システム開発とデジタル…

中小企業の属人化・問い合わせ対応をAIで自動化。セキュアなDify自己ホスト型チャットボット導入を10万円で専門家が支援。

ミラーマスター合同会社|千葉のDX…

【製造業向け】業務改善・DX支援コンサル – ミラーマスター合同会社|千葉のDX・システム開発とデジタル事…

製造業の経営者様へ。生産性向上・コスト削減を実現。40年の現場経験を持つ専門家が貴社のDXを伴走支援します。

ミラーマスター合同会社|千葉のDX…

中小企業のシステム開発伴走支援 – ミラーマスター合同会社|千葉のDX・システム開発とデジタル事業創造

「誰に頼めば…」とお悩みの中小企業様へ。40年の経験を持つ代表が貴社の開発プロジェクトを成功に導きます。全国対応。

現場知×AI:製造業DX実践ブログ

製造業AI活用の本質|現場知を資産に変えるミラーマスター – 現場知×AI:製造業DX実践ブログ

現場を歩かないITは信じない。40年の経験でAI精度「32.7%の罠」を回避し、10万円から現場知を資産化する「泥臭い」エンジニアリングを提供します。

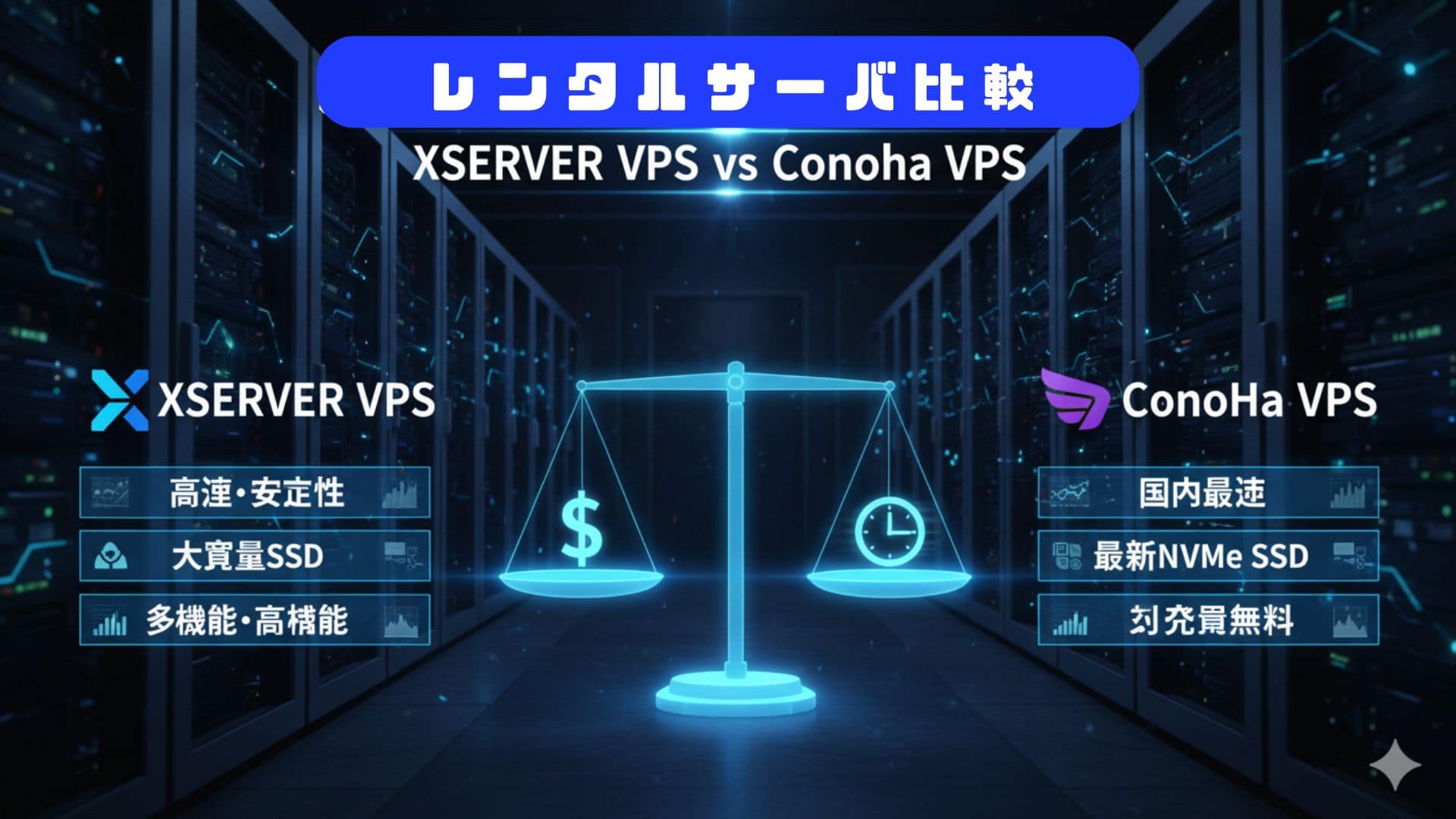

VPSサーバの選定

起業のためのシステム化

Difyに最適なVPS比較 XServer vs ConoHa

DifyでAI構築!XServer VPSとConoHa VPSを徹底比較。初心者におすすめの料金、簡単さ、スペックを解説します。

起業のためのシステム化

エックスサーバーのおすすめは?WordPress・VPS比較

国内シェアNo.1「エックスサーバー」のおすすめは?WordPressからVPS、法人利用まで、目的別に最適なプランを徹底解説。

起業のためのシステム化

ConoHaのおすすめは?WINGとVPSを徹底比較

ConoHaのおすすめは?WordPress(WING)、AI(VPS)、FXなど目的別に全サービスを比較。最適なプランが見つかります。

コメント