序論:眩暈がするほどの加速

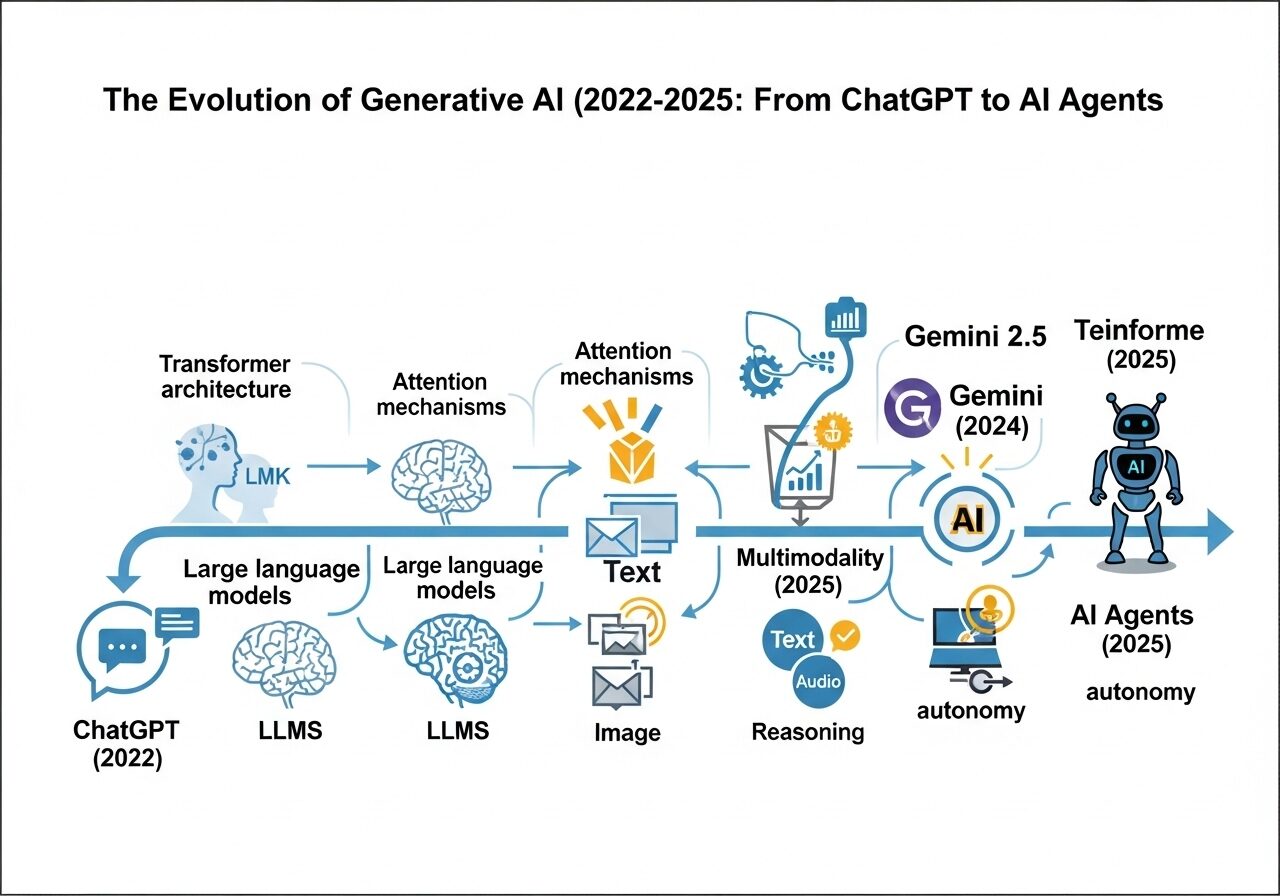

2022年後半から2025年初頭にかけての期間は、前例のない技術的変曲点として歴史に刻まれるだろう。この変化の速度は、多くの人々にとって「眩暈がする」と表現されるほど圧倒的であった。この革命の火付け役となったのは、真に有能な対話型AIと一般大衆が初めて広範囲に接触した瞬間である。本稿のタイムラインの終点に位置するGoogleの「Gemini 2.5 Pro Experimental」のようなモデルは、複雑なタスクをこなし、長大な文脈を理解し、人間と見紛うほどの自然さで対話する能力を持つ。わずか2年余り前の技術水準を考えると、この進歩は驚異的としか言いようがない。

この知性の「カンブリア爆発」は、単一のブレークスルーによって引き起こされたものではない。本稿では、この現象がTransformerアーキテクチャの成熟、スケーリング則(Scaling Laws)の有効性の証明、大規模な資本投下、熾烈な市場競争、そしてオープンソース貢献による民主化という、複数の要因が合流した結果であることを論じる。本稿は、技術と私たちの関係を再定義した主要なマイルストーンを時系列的かつテーマ別に辿ることで、この激動の軌跡を包括的に分析することを目的とする。

第1章 発端の瞬間:対話型AI時代の幕開け(2022年後半~2023年初頭)

1.1 ChatGPT現象(2022年11月30日)

2022年11月30日、OpenAIはChatGPTを一般公開し、世界に衝撃を与えた。このサービスは既存のGPT-3ファミリーのモデルを基盤としていたが、その真の革新性は、誰でも直感的に利用できる対話型インターフェースにあった。これにより、大規模言語モデル(LLM)は一部の研究者のツールから、世界的な現象へと変貌を遂げた。公開後わずか5日間で100万人以上の登録者を獲得したという事実は、そのインパクトの大きさを物語っている。

ChatGPTの初期の能力は、GPT-3.5アーキテクチャに基づき、テキスト生成、翻訳、要約、基本的なコード生成など多岐にわたった。しかし、その能力には限界も存在した。特に「ハルシネーション」と呼ばれる、もっともらしいが事実に基づかない、あるいは無意味な情報を生成する傾向は、初期のモデルが抱える深刻な課題であった。また、リアルタイムの情報にアクセスできないため、その知識は訓練データがカットオフされた時点に限定されていた。このため、当初は魅力的でありながらも、時に信頼性に欠けるツールとして認識されていた。

この時期の最も重要な教訓は、技術的な飛躍がモデル自体の性能向上だけでなく、直感的で対話的なインターフェースの創出にあったという点である。GPT-3は2020年からAPIを介して開発者に利用可能であったが、その利用は技術的な専門知識を持つ層に限られていた。ChatGPTは、この高度な技術をチャット形式でパッケージ化することで、技術者でない数百万人のユーザーに直接的なアクセスを可能にした。この大規模なインタラクションが前例のない世間の関心とメディアの注目を集め、Googleのような競合他社に迅速な公的対応を余儀なくさせたのである。したがって、技術のユーザーフレンドリーな製品化が、AIブームを触発する上で技術そのものと同じくらい重要であったことがわかる。

1.2 業界の反応:Googleの「コードレッド」

ChatGPTの登場は、特に情報検索市場を支配してきたGoogleにとって、存亡に関わる脅威として受け止められた。報道によると、Googleの経営陣は「コードレッド」警報を発令し、複数のチームをAI関連の取り組みに再配置し、共同創業者であるラリー・ペイジとセルゲイ・ブリンを緊急会議に呼び戻して対応を協議したとされる。

これに対するGoogleの迅速な回答が、2023年2月6日に発表されたLaMDAモデルを搭載した「Bard」であった。これは明らかにChatGPTへの直接的な対抗策であった。Googleは以前から同様の能力を持つAIを開発していたが、強力なAIを一般公開することに伴う「評判リスク」を懸念し、慎重な姿勢を保っていた。Bardはまず「信頼できるテスター」に限定公開された後、2023年3月21日に米国と英国で一般公開された。この一連の動きは、ChatGPTの登場がいかに既存の巨大企業に戦略の転換を強いたかを示す象徴的な出来事であった。

1.3 初期エコシステム:先行者と機能拡張

ChatGPTが世界的な注目を集める中で、AIを特定のワークフローに組み込むことで具体的な価値を提供するサービスも台頭し始めていた。

GitHub Copilotは、その代表例である。2021年に発表されたこのAIペアプログラマーは、開発者の生産性を大幅に向上させるツールとして、本格的なエージェントブームに先駆けてその地位を確立していた。調査によれば、Copilotを使用する開発者はタスクを最大55%速く完了させることができ、これはLLMを特化したワークフローに統合することの直接的な商業的価値を証明するものであった。

また、2022年12月に登場したPerplexity AIは、検索エンジンのパラダイムを根底から揺るがした 。その革新性は、LLMによる直接的な回答生成とリアルタイムのウェブ検索を組み合わせ、さらにその情報の引用元を明記する点にあった。これは、初期のChatGPTが抱えていた最新情報の欠如と情報源の不透明性という二つの大きな弱点を直接的に解決するものであり、従来の「青いリンクのリスト」を提示する検索モデルに対する根本的な挑戦であった。

ChatGPTやPerplexity AIの初期バージョンは完璧ではなかったが、多くのユーザーにとって「十分に良い(good enough)」性能を提供することで、既存のプレイヤーを揺るがすのに十分であった。ChatGPTはハルシネーションを起こすことがあったが、メールの下書きやブレインストーミングといった一般的な用途での有用性は非常に高く、大規模な普及を達成した。この事実は、市場破壊に完璧さは必須条件ではなく、一般的なユースケースで大きな価値を提供することがユーザーの行動を変える鍵であることを示している。これにより、より高い「評判リスク」基準の下で運営されていたGoogleのような既存企業は戦略的な不利を被り、自社製品の市場投入を加速せざるを得なくなったのである。

表1:主要な生成AIモデル&サービス発表タイムライン(2022年8月~2025年3月)

| 日付 | 組織 | モデル/サービス | 意義 |

|---|---|---|---|

| 2022年8月22日 | Stability AI 他 | Stable Diffusion | 高性能なオープンソース画像生成モデルの登場 |

| 2022年11月30日 | OpenAI | ChatGPT | 対話型AIを世界的な現象へと押し上げた起爆剤 |

| 2022年12月 | Perplexity AI | Perplexity | 引用元を提示するAI検索エンジンとして新たなパラダイムを提示 |

| 2023年3月14日 | OpenAI | GPT-4 | 専門試験で人間レベルの性能を示し、マルチモーダル機能を持つモデル |

| 2023年3月14日 | Anthropic | Claude | 「Constitutional AI」による安全性と倫理性を重視したモデル |

| 2023年3月21日 | Bard | GoogleのChatGPTへの直接的な対抗サービス(米国・英国で提供開始) | |

| 2023年7月18日 | Meta | Llama 2 | 高性能なオープンソースLLMの登場でAI開発の民主化を加速 |

| 2023年9月 | OpenAI | GPT-4V | GPT-4に画像入力機能が本格的に搭載され、マルチモーダル化が進展 |

| 2024年2月15日 | OpenAI | Sora | テキストから高品質な動画を生成するモデルをプレビュー公開 |

| 2024年3月4日 | Anthropic | Claude 3 | 業界ベンチマークを更新し、Opus、Sonnet、Haikuの3モデル体制を発表 |

| 2024年5月13日 | OpenAI | GPT-4o | 音声・画像・テキストを統合した高速・低コストなネイティブマルチモーダルモデル |

| 2024年6月20日 | Anthropic | Claude 3.5 Sonnet | Claude 3 Opusを上回る性能を持つ、より高速でコスト効率の高いモデル |

| 2024年9月12日 | OpenAI | OpenAI o1 | 「思考時間」を持つことで複雑な論理的推論能力を強化したモデル |

| 2025年1月20日 | DeepSeek | DeepSeek-R1 | 少ないパラメータ数で高性能を実現し、スケーリング則に疑問を投げかけたモデル |

| 2025年2月24日 | Anthropic | Claude 3.7 Sonnet | 迅速な応答と段階的な思考を両立するハイブリッド推論モデル |

| 2025年3月26日 | Gemini 2.5 Pro Exp. | 高度な推論能力とコーディング能力を備えた次世代モデル |

第2章 軍拡競争:多極化するAIの世界(2023年)

2023年は、生成AI分野が単一のプレイヤーによる支配から、複数の強力な競合がしのぎを削る多極化したエコシステムへと移行した年であった。OpenAIが性能の基準を引き上げ続ける一方で、独自の哲学を持つ競合や、オープンソースという異なる戦略を取る勢力が台頭し、市場は急速に複雑化していった。

2.1 OpenAIの飛躍的進化:GPT-4(2023年3月14日)

2023年3月14日、OpenAIはGPT-4をリリースし、性能の基準を劇的に引き上げた。GPT-4は、GPT-3.5を遥かに凌駕する能力を示し、特に専門的・学術的なベンチマークにおいて人間レベルの性能を達成した 。その最も象徴的な成果の一つが、模擬司法試験において、GPT-3.5が下位10%程度のスコアであったのに対し、GPT-4は上位10%に入るスコアを記録したことである。これは、AIが単なる言語処理ツールから、高度な専門知識を要する領域でも実用的な能力を発揮しうることを示した。

さらに重要なのは、GPT-4が当初から画像とテキストの両方を入力として受け取れる大規模マルチモーダルモデルとして設計されていた点である。画像入力機能(GPT-4V)の一般提供は段階的であったが、このアーキテクチャは、AIがテキストの領域を超えて、より多様な情報を統合的に理解する未来を予感させた。

一方で、OpenAIは戦略的な二層構造を明確にした。GPT-4が性能の頂点を極める一方で、ほぼ同時期にリリースされたGPT-3.5 Turboは、従来モデルの10分の1という劇的に低いコストと高速な応答性能を実現した。この経済的なアクセシビリティが、スタートアップや個人開発者によるAIアプリケーション開発の爆発的な増加を促し、エコシステム全体の成長を力強く牽引した。

2.2 競合の確立:AnthropicとGoogle

OpenAIの独走を許すまいと、競合他社も独自の強みを打ち出し始めた。

元OpenAIのメンバーによって設立されたAnthropicは、2023年3月14日にClaudeをリリースした。彼らの最大の特徴は、「Constitutional AI」という独自の開発哲学にある。これは、AIの安全性を確保するために、人間による継続的なフィードバックに依存するのではなく、国連の世界人権宣言などに着想を得た一連の倫理原則(憲法)をモデルの訓練プロセスに組み込むアプローチである。具体的には、まずモデルが自らの応答を「憲法」に基づいて自己批判・修正する教師あり学習フェーズがあり、次にAI自身が生成したフィードバックを用いて強化学習(RLAIF)を行う。これにより、「有益で、正直で、無害な」AIアシスタントの実現を目指した。このアプローチは、AIの安全性や倫理性を重視する企業にとって大きな魅力となり、Anthropicを独自の地位に押し上げた。

一方、GoogleはBardの提供開始後も開発を続け、2024年2月8日にはブランドを「Gemini」に刷新した。これは単なる名称変更ではなく、より高性能で、当初からマルチモーダルを前提として設計された新世代モデルへの移行を意味していた。これにより、Googleは単なる追随者から、独自のアーキテクチャとビジョンを持つ強力なイノベーターへと変貌を遂げた。

2.3 オープンソースという対抗軸

クローズドなモデル開発が主流となる中で、全く異なる戦略がAIエコシステムに大きな影響を与えた。それがオープンソース化の流れである。

その中心にいたのがMetaであり、2023年7月18日にLlama 2をリリースしたことは、この年の画期的な出来事の一つであった。Metaの戦略は、基盤モデルそのものをコモディティ化(汎用品化)することにあった。モデルを無償で公開することで、世界中の開発者や研究者が自由に改良・応用できるようにし、それによってMeta自身のプラットフォームやハードウェアへの需要を喚起する。また、開発コストをグローバルなコミュニティに分散させ、優秀な人材を引きつけ、AI開発の民主化を推進するリーダーとしての地位を確立するという狙いもあった。

Llama 2の登場は、エコシステムに即座に、そして深く浸透した。企業は、データプライバシーやコストを自社で管理しながら、高性能なモデルをオンプレミス環境で利用できるようになった。これにより、特定の業界やタスクに特化した無数の派生モデルが生まれ、イノベーションが分散・加速した。また、フランスのMistral AIのような新たなプレイヤーも高性能なオープンソースモデルを次々と発表し、この流れをさらに強力なものにした。なお、画像生成の分野では、ChatGPT登場以前の2022年8月22日にオープンソースモデル「Stable Diffusion」が公開されており、生成AIにおけるコミュニティ主導開発の先例となっていた。

2023年を通じて、AI市場は三つの異なる戦略的陣営へと明確に分化した。第一に、OpenAIは最高の性能を持つクローズドなAPI駆動モデルで市場をリードした。第二に、GoogleとAnthropicは、それぞれ独自のアーキテクチャ(ネイティブマルチモーダル)と倫理哲学(Constitutional AI)を掲げ、垂直統合型の競合として存在感を示した。そして第三に、Metaが触媒となった、分散型で急速に革新を進めるオープンソースエコシステムが確立された。この三極構造が、互いに影響を与え合いながら、生成AIの進化を加速させる原動力となったのである。

第3章 言葉を超えて:マルチモーダル革命(2024年)

2024年は、生成AIがテキストという単一の様式(モダリティ)から脱却し、画像、音声、動画といった複数のモダリティを統合的に扱う「マルチモーダル」の時代へと本格的に突入した年であった。この変化は、AIが単に言語を処理するだけでなく、人間のように多様な感覚情報を通じて世界を理解し始める第一歩を印した。

3.1 Soraの衝撃(2024年2月)

2024年2月、OpenAIはテキストから動画を生成するモデル「Sora」のデモンストレーションを公開し、世界に衝撃を与えた。公開された動画は、単なる映像の断片ではなく、物理法則や物語の一貫性を保った、驚くほど写実的で創造的なものであった。これは、Transformerアーキテクチャが言語の枠を超え、視覚的な世界の動的な側面をモデル化する能力を持つことを鮮烈に示した瞬間であった。Soraの登場は、コンテンツ制作の未来を根底から変える可能性を示唆し、Googleの「Veo」やRunwayの「Gen-3 Alpha」といった競合他社も追随して同様のモデルを発表するなど、新たな開発競争の火蓋を切った。

3.2 オムニモデルの到来:GPT-4o(2024年5月13日)

Soraが動画生成の未来を示した数ヶ月後、OpenAIは2024年5月13日にGPT-4o(「o」は「omni」を意味する)をリリースし、マルチモーダルAIの概念を再定義した。GPT-4oの最大の革新は、テキスト、音声、画像を単一のニューラルネットワークでエンドツーエンドに処理する「ネイティブマルチモーダル」モデルであった点にある。

このアーキテクチャがもたらした最も劇的な変化は、音声対話の体験であった。従来の音声アシスタントは、「音声認識(Whisper)→テキスト処理(GPT-4)→音声合成(TTS)」という複数のモデルを組み合わせたパイプライン方式を採用していた。この方式では、各ステップでの処理遅延が積み重なり、応答までに数秒の不自然な間が生じていた。対照的に、GPT-4oは音声入力を直接処理し、話者の声のトーンや感情、背景の音といった非言語的な情報まで理解することができた。これにより、応答遅延は平均320ミリ秒にまで短縮され、これは人間の対話における応答時間とほぼ同等である。これは単なる速度向上ではなく、人間とAIのインタラクションを根本的に変える質的な飛躍であった。さらに、GPT-4oはGPT-4 Turboを上回る性能を持ちながら、コストは大幅に低減されており、高度なマルチモーダルAIの普及を加速させる決定的な一歩となった。

3.3 戦略的差別化としてのネイティブマルチモーダル:Geminiアーキテクチャ

OpenAIがGPT-4oでマルチモーダルインタラクションの新たな基準を打ち立てた一方で、Googleは「Gemini」において、アーキテクチャレベルでのネイティブマルチモーダルを戦略の中核に据えていた。Geminiは、後から視覚や聴覚の機能を追加するのではなく、開発当初からテキスト、画像、音声、動画といった多様なデータをシームレスに扱うことを前提に設計されていた。

このアーキテクチャの技術的利点は大きい。複数のモデルを組み合わせるパイプライン方式では、例えば画像をテキストに変換する段階で、元の画像が持つ豊かな情報やニュアンスが失われる可能性がある。しかし、Geminiのような統一されたTransformerアーキテクチャでは、異なるモダリティのデータがモデルの各層で直接的に相互作用する「クロスモーダルアテンション」が可能となる。これにより、モデルは画像とその説明文、あるいは動画とその音声といった異なる種類の情報間の深い関係性を学習し、より高度で洗練された推論を行うことができる。例えば、放射線科医がX線画像と患者のカルテ、検査結果を同時にAIに入力し、統合的な診断支援を受けるといった、より複雑な応用が可能になる。

2024年におけるマルチモーダルの進化は、AIが単なる「言語モデル」から、より包括的な「ワールドモデル」へと移行し始めたことを示している。テキストだけでなく、視覚や聴覚といった多様な情報源から世界を統合的に理解する能力は、AIがより一般的で汎用的な知能へと向かう上で不可欠なステップである。GPT-4oが示した人間レベルの応答速度は、AIが単なるツールから自然な対話パートナーへと進化する上で、「遅延」がいかに重要な障壁であったかを浮き彫りにした。このブレークスルーにより、リアルタイム翻訳や対話型教育といった応用が、単に可能なだけでなく、実用的で快適なものとなったのである。

第4章 自律性の夜明け:推論とエージェント(2024年後半~2025年初頭)

2024年後半から2025年初頭にかけて、生成AIの進化は新たな次元へと突入した。それは、単に情報を生成・応答するだけでなく、与えられた目標を達成するために自律的に計画を立て、複数のステップを実行する「AIエージェント」の時代の幕開けである。この飛躍の背景には、複雑な問題を段階的に解決する「推論(reasoning)」能力に特化した新世代モデルの登場があった。

4.1 「思考する」機械の出現:OpenAIのo1(2024年9月12日)

2024年9月12日、OpenAIは「o1」モデルシリーズを発表し、AIの競争軸を根本的に変えた。o1の最大の特徴は、応答を生成する前に内部で「思考の連鎖(chain of thought)」を生成することで、高度な論理的推論能力を実現した点にある。この意図的な「思考時間」により、モデルは複雑な問題をより小さな中間ステップに分解し、一つ一つ解決していくことが可能になった。

この能力は、特に科学、技術、工学、数学(STEM)の分野で劇的な性能向上をもたらした。例えば、米国の難関数学コンテストであるAIME(American Invitational Mathematics Examination)において、GPT-4oの正答率が13%であったのに対し、o1は83%という驚異的なスコアを記録した。これは、AIが単に知識を記憶・検索するだけでなく、真の問題解決能力を獲得し始めたことを示す画期的な成果であった。これまでのモデルが「何(what)」という問いに答えることに長けていたとすれば、o1のような推論モデルは「どのように(how)」という問い、すなわち問題解決のプロセスそのものを扱う能力を手に入れたのである。

4.2 AIエージェントの台頭

推論モデルの登場は、AIの役割を根本的に変えた。それまでのAIがユーザーの指示に受動的に応答する「アシスタント」であったのに対し、新たなAIは目標達成のために自律的に行動する「エージェント」へと進化した。

その象徴的な存在が、自律型AIソフトウェアエンジニアとして登場した「Devin」である。Devinは、単なるコード補完ツール(GitHub Copilotのような「ペアプログラマー」)とは一線を画す。統合されたシェル、エディタ、ブラウザ環境を持ち、与えられたタスク(例えば「このバグを修正せよ」)に対して、自ら計画を立て、ドキュメントを検索し、コードを記述・実行し、エラーをデバッグするという一連のプロセスを、最小限の人間の監督下で自律的に実行する能力を持つ。

Devinの登場を皮切りに、特にソフトウェア開発の分野でエージェント型サービスが爆発的に増加した。自然言語の指示だけで、バックエンドからフロントエンドまでを含む完全なアプリケーション(フルスタック)を自動生成するツールも次々と現れ、AIがデジタル世界で具体的な「作業」を代行する時代の到来を告げた。この変化は、ユーザーとAIの関わり方を、直接的な対話から目標指向の「委任」へとシフトさせた。LLMは、ツールを使い、情報にアクセスし、デジタル世界で行動する自律システムの「CPU」としての役割を担い始めたのである。

4.3 新世代統合モデル(2025年初頭)

2025年初頭には、これまでの進化の集大成とも言える新世代モデルが次々と登場した。

2025年3月26日に発表されたGoogleのGemini 2.5 Pro Experimental や、同年2月24日に発表されたAnthropicのClaude 3.7 Sonnet などがその代表格である。これらのモデルは、ネイティブマルチモーダル能力、高度な推論能力(Claude 3.7のように明示的な「思考」モードを持つものもある)、そして複雑なAIエージェントの中核エンジンとして機能する能力を、単一のフレームワーク内に統合している。

この競争が激化する中で、2025年1月20日に中国のDeepSeek社が発表したオープンソースモデル「DeepSeek-R1」は、業界に新たな波紋を広げた。DeepSeek-R1は、主要なクローズドモデルと比較して大幅に少ないパラメータ数で同等以上の性能を達成したと報告された。これは、モデルの性能はサイズ、データ量、計算量に比例して向上するという、長らく信じられてきた「スケーリング則」が絶対ではない可能性を示唆した。この効率性の鍵となったのが、特定のタスクに応じてモデル内の一部の専門家(エキスパート)ネットワークのみを活性化させる「Mixture-of-Experts(MoE)」アーキテクチャであると見られている。この出来事は、AIの性能向上が、単なる規模の拡大だけでなく、より洗練されたアーキテクチャの革新によってもたらされる新時代の到来を予感させた。

表2:主要フラッグシップモデルの比較分析(2025年初頭)

| 特徴 | OpenAI (GPT-4o / o1) | Google (Gemini 2.5 Pro) | Anthropic (Claude 3.7 Sonnet) |

|---|---|---|---|

| 主要な差別化要因 | 専門的な推論能力(o1)とリアルタイムマルチモーダル対話(GPT-4o) | ネイティブマルチモーダルアーキテクチャとGoogleエコシステムとの深い統合 | 安全性と倫理性を重視した「Constitutional AI」とハイブリッド推論 |

| マルチモーダリティ | テキスト、音声、画像を単一モデルで処理。リアルタイム音声対話に強み | 開発当初からマルチモーダルを前提とした統一アーキテクチャ | テキスト、画像入力に対応。特に長文読解と分析に優れる |

| コンテキストウィンドウ | 128Kトークン | 1Mトークン以上(モデルによる) | 200Kトークン |

| 推論能力 | o1モデルは「思考の連鎖」によりSTEM分野で卓越した性能を発揮 | 高度な推論能力とコーディング能力を特徴とする | 迅速な応答と段階的な「思考」モードを切り替え可能なハイブリッド推論 |

| 主要なエージェント機能 | 自律的なタスク実行とツール連携を可能にする推論エンジンを提供 | 複雑なタスクの自律的実行、ウェブ検索、感情分析などを統合 | コーディングエージェント「Claude Code」を提供し、開発タスクを自動化 |

| 根底にある哲学 | 性能の限界を追求し、汎用知能(AGI)への道筋を探る | AIをすべての製品とサービスに統合し、情報を整理しアクセス可能にする | 「有益で、正直で、無害な」AIの実現を最優先する |

第5章 成長のエンジン:AI爆発の触媒たち

2022年から2025年にかけての生成AIの驚異的な進化は、モデル自体の改良だけでなく、それを支える foundational な技術、ハードウェア、エコシステム、そしてアプリケーションの好循環によってもたらされた。この章では、AI爆発を可能にした核心的な触媒を分析する。

5.1 基礎となるアーキテクチャと原則

生成AI革命の全ての基盤となっているのが、2017年の論文「Attention Is All You Need」で発表されたTransformerアーキテクチャである。その核心的なメカニズムである**自己注意(Self-Attention)**は、それ以前のRNN(再帰型ニューラルネットワーク)のような逐次的な処理から脱却し、入力シーケンス内のすべての単語間の関連性を並列的に計算することを可能にした。これにより、文脈における長距離の依存関係を効率的に捉えることができ、自然言語処理の性能が飛躍的に向上した。

このアーキテクチャの有効性を最大化したのが**スケーリング則(Scaling Laws)**の証明である。これは、モデルのパラメータサイズ、訓練データ量、そして訓練に使用する計算量を増大させれば、性能が予測可能に向上するという法則である。GPT-4のような巨大なモデルが、莫大なリソースを投じて訓練され、圧倒的な性能を示したことで、この法則の有効性が広く認識された。これが「大規模な投資を行えば、さらに優れたものが作れる」という確信を生み、テクノロジー企業による巨額の投資競争を正当化し、加速させる大きな要因となった。

5.2 ハードウェアのバックボーン:NVIDIAの支配

Transformerアーキテクチャとスケーリング則が理論的な道筋を示した一方で、それを物理的に可能にしたのが、NVIDIAに代表される高性能なGPU(Graphics Processing Unit)であった。LLMの訓練には、膨大な行列計算を並列処理する能力が不可欠であり、GPUはそのために最適なハードウェアであった。

特に、NVIDIAのA100からH100への世代交代は、AI開発のペースを決定づける重要な要素であった。H100は、AIワークロードにおいてA100を遥かに凌ぐ性能向上を実現した。その鍵となったのが、H100に新たに搭載されたTransformer Engineである。この専用ハードウェアは、モデルの精度を損なうことなく、より計算効率の高い低精度演算(FP8)を動的に活用することで、Transformerベースのモデルの処理を劇的に高速化する。結果として、H100はA100と比較して、LLMの訓練で最大9倍、推論で最大30倍の高速化を達成した。このハードウェアの飛躍的な進化が、より大規模で高性能なモデルを現実的な時間とコストで開発することを可能にし、AIの進化を直接的に支えたのである。このハードウェアとソフトウェアの共進化は、AI革命の重要な特徴である。TransformerアーキテクチャがGPUによる並列処理に適していたことが初期の成功を導き、その成功がNVIDIAにTransformerに特化したハードウェア(H100)への投資を促し、そのハードウェアがさらに大規模なモデルの開発を可能にするという、強力な相乗効果が生まれた。

表3:AIワークロードにおけるNVIDIA GPUの進化(A100 vs. H100)

| 特徴 | NVIDIA A100 (Ampere) | NVIDIA H100 (Hopper) |

|---|---|---|

| アーキテクチャ | Ampere | Hopper |

| 主要な革新 | 第3世代Tensorコア、TF32精度サポート | Transformer Engine、第4世代Tensorコア、FP8精度サポート |

| メモリ(帯域幅) | 最大80 GB HBM2e (最大2 TB/s) | 80 GB HBM3 (最大3.35 TB/s) |

| 性能(LLM訓練) | ベースライン | 最大9倍高速 (実質2-3倍の高速化が報告されている) |

| 性能(LLM推論) | ベースライン | 最大30倍高速 |

| 戦略的影響 | 大規模AIモデルの訓練を主流にした | Transformerモデルの訓練・推論コストを劇的に削減し、モデルのさらなる大規模化と迅速な開発サイクルを可能にした |

5.3 オープンエコシステムの力

巨大テック企業によるクローズドな開発競争と並行して、オープンソースコミュニティがイノベーションのもう一つの重要なエンジンとなった。MetaによるLlamaシリーズの公開は、その象徴である。高性能な基盤モデルが自由に利用可能になったことで、世界中の何千もの開発者や研究者が、コストの制約なく最先端の技術にアクセスできるようになった。これにより、特定のニーズに合わせてモデルをファインチューニングしたり、新たな応用方法を実験したりすることが容易になり、イノベーションの裾野が爆発的に広がった。このオープンなアプローチは、AIの専門知識と開発能力が一部の巨大企業に集中することを防ぎ、エコシステム全体の多様性と活力を促進した。

5.4 アプリケーションとフィードバックの好循環

AIモデルの進化は、それを活用するためのツールやフレームワークの発展と密接に連携していた。LangChainやLlamaIndexのような開発フレームワークは、その代表例である。LangChainは、LLMを外部のAPIやツールと連携させるためのモジュール(「チェーン」や「エージェント」)を提供し、複雑なアプリケーションの構築を容易にした。一方、LlamaIndexは、LLMを独自のデータソースに接続することに特化し、RAG(Retrieval-Augmented Generation)アプリケーション開発の標準的なツールとなった。

これらのフレームワークが、GPT-3.5 TurboやオープンソースモデルのようなアクセスしやすいAIと組み合わさることで、実用的なアプリケーションの開発が爆発的に増加した。そして、これらのアプリケーションが広く使われることで、膨大な量のユーザーインタラクションデータやフィードバックが収集された。このデータが次世代モデルの改善や新たな応用分野の発見に活用され、モデルの性能向上とアプリケーションの普及が互いを加速させるという、強力な「好循環(フライホイール効果)」が生まれたのである。このエコシステムの成熟は、AI技術スタックの階層化という形で現れた。下層にはハードウェア(NVIDIA)、その上に基盤モデル(OpenAI、Google、Llama)、さらにその上にアプリケーションフレームワーク(LangChain、LlamaIndex)が位置し、開発者は各層の専門知識なしにアプリケーションを構築できるようになった。これは、技術が研究段階から成熟した工学分野へと移行している明確な兆候である。

第6章 新たな現実との向き合い方:永続する課題と今後の道筋

生成AIの急速な進化は、計り知れない可能性を切り拓く一方で、技術的、倫理的、社会的に解決すべき多くの課題を浮き彫りにした。モデルの能力が向上するにつれて、その信頼性、安全性、そして悪用のリスクに対する懸念も増大している。

6.1 未解決の技術的課題

6.1.1 ハルシネーションと事実の信頼性

モデルの性能が大幅に向上したにもかかわらず、「ハルシネーション」という根本的な問題は依然として残っている。これは、モデルがもっともらしいが事実と異なる、あるいは全くの虚偽の情報を生成する現象である。実際に、ChatGPTを法的調査に使用した弁護士が、AIが捏造した判例を引用した準備書面を裁判所に提出するという事件も発生している。この種の事例は、特に医療、金融、法務といったハイステークスな分野において、AIの出力を鵜呑みにすることの危険性と、人間による徹底した事実確認と監督が不可欠であることを示している。

6.1.2 内在するバイアス

生成AIが抱えるもう一つの深刻な課題は、バイアスである。インターネット上の膨大なテキストや画像データを学習するモデルは、そのデータに内在するジェンダー、人種、文化に関する社会的な偏見を必然的に吸収し、増幅させてしまう。具体的な事例として、画像生成モデルが「CEO」というプロンプトに対して白人男性の画像を、「看護師」に対して女性の画像を生成する傾向や、顔認識システムが有色人種の女性に対して高いエラー率を示すといった問題が報告されている。これらのバイアスは、AIが社会的なステレオタイプを再生産・固定化し、不平等を助長するリスクをはらんでいる。

6.2 諸刃の剣:悪意ある利用

生成AIの能力は、悪意ある者にとっても強力な武器となる。特にディープフェイク技術の進化と普及は、新たな脅威を生み出している。

6.2.1 2,500万ドルのディープフェイク強盗事件

この脅威を象徴するのが、多国籍エンジニアリング企業Arupを標的とした詐欺事件である。詐欺師は、同社のCFO(最高財務責任者)や他の幹部の容姿と声を模倣したディープフェイク動画を作成し、オンライン会議を実施した。この会議に騙された従業員は、詐欺師の指示に従い、2,500万ドル(約38億円)を送金してしまった。この事件は、AIが人間の信頼を巧みに悪用し、従来のセキュリティ対策を迂回する高度なソーシャルエンジニアリング攻撃を可能にすることを示した。同様の手口で、CEOの声をクローン化して従業員を騙そうとする詐欺は、LastPassやFerrariといった企業でも報告されており、その手口はますます巧妙化している。

6.2.2 サイバー犯罪の敷居の低下

ディープフェイクだけでなく、生成AIはより広範なサイバー犯罪のハードルを下げている。専門的な知識がない攻撃者でも、文法的に完璧なフィッシングメールをあらゆる言語で大量に生成したり、悪意のあるコードを記述させたり、あるいは個人情報を基にしたパスワード推測を高速化したりすることが可能になった。これにより、サイバー攻撃の量と質が共に向上し、社会全体のセキュリティリスクが増大している。

6.3 ガードレールをめぐる競争:世界の規制動向

AIがもたらすリスクに対応するため、世界各国で規制の枠組み作りが急がれているが、そのアプローチには顕著な違いが見られる。

6.3.1 欧州のアプローチ:EU AI法

欧州連合(EU)は、包括的かつリスクベースのアプローチを取る「AI法」を制定した。2024年7月12日に官報で最終テキストが公開されたこの法律は、AIシステムを4つのリスクレベルに分類する。中国で行われているような政府によるソーシャルスコアリングや、公共の場でのリアルタイム生体認証といった「許容できないリスク」を持つAIは全面的に禁止される。一方、重要インフラ、採用、信用評価などに使われる「高リスク」AIには、リスク評価、データ品質、人間による監督など、市場投入前に厳格な義務が課される。この法律は2025年初頭から段階的に適用が開始される予定であり、個人の基本的権利の保護を最優先するEUの姿勢を明確に示している。

6.3.2 米国のアプローチ:イノベーションと規制緩和

対照的に、2025年の「AIアクションプラン」および関連する大統領令に示された米国の方針は、国際競争における優位性を確保するため、イノベーションの加速を最優先するものである。この計画は、AI開発を妨げる既存の規制を撤廃・見直し、データセンターのようなAIインフラの建設許可プロセスを迅速化することを目的としている。これは、規制よりも市場主導のイノベーションを重視し、経済成長と国家安全保障を推進するという明確な戦略的選択である。

このように、EUと米国で示されたアプローチの根本的な哲学の違いは、AIガバナンスにおける世界的な分裂の始まりを示唆している。GDPR(一般データ保護規則)で見られた「ブリュッセル効果」のように、一方の規制が事実上の世界標準となる可能性もあれば、異なる規制哲学に沿った別々のAIエコシステムが形成され、多国籍企業が複雑なコンプライアンス対応を迫られる未来も考えられる。

結論:プロンプトからエージェントへ

本稿で概観したように、2022年後半から2025年初頭にかけての期間は、生成AIが驚異的な進化を遂げた時代であった。その軌跡は、最初のChatGPTが示した単純な「プロンプトと応答」のパラダイムから、自律的に目標を達成するために行動する「AIエージェント」の登場へと、わずか2年余りで駆け抜けた。

2025年初頭の現在、最先端のAIモデルはもはや単なるコンテンツ生成ツールではなく、自律的な行動のためのプラットフォームとなりつつある。焦点は、コンテンツを「生成する」ことから、タスクを「達成する」ことへと明確に移行した。

この進化の先に何が待っているのかを断定的に予測することは困難であるが、業界と社会が直面するであろう戦略的な問いを提示することで、本稿の結論としたい。

- スケーリング則が限界に達しつつある可能性が示唆される中、今後のブレークスルーは、DeepSeek-R1のようなアーキテクチャの革新から生まれるのか、あるいは全く新しい訓練パラダイムから生まれるのか?

- オープンソースエコシステムは、垂直統合された巨大テック企業の莫大なリソースに対抗し、そのイノベーションのペースを維持できるのか?

- 自律型AIエージェントが、ソフトウェア工学、法務、科学といった専門分野において、単なる反復作業だけでなく、複雑な認知的ワークフローの自動化を始めたとき、社会はどのように適応していくのか?

- そして最も重要な問いとして、我々は、この強力な技術がもたらす深刻なリスクを管理するための安全性、倫理、そして規制のガードレールを確立するという重要な必要性と、急速なイノベーションを求める衝動との間の緊張関係を、うまく乗り越えることができるのだろうか?

これらの問いに対する答えが、これからのAIと人類の未来を形作っていくことになるだろう。

【推奨】業務システム化に有効なアイテム

生成AIを学ぶ

システム化のパートナー(ミラーマスター合同会社)

VPSサーバの選定

コメント